Lembrando que o HDD é um processo orientado a hipótese com foco principal em validação das ideias sob a perspectiva de geração de ROI e satisfação dos usuários. Para isso, um processo maduro de CI (Continuous Integration) e CD (Continuous Deployment) habilita a esteira de validação de ideias e suporte imediato.

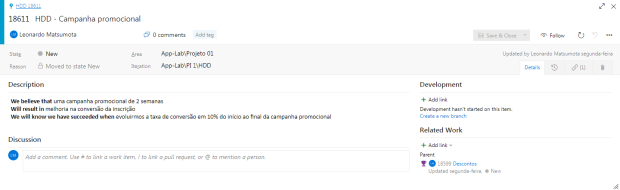

Ao formular as hipóteses, utiliza-se os conceitos da experimentação, e por isso a user story é insuficiente para verificar se a hipótese está correta. Na HDD criada, existe uma validação de hipótese referente a uma campanha promocional que pode aumentar a taxa de conversão.

Iniciando a implementação do HDD em um time cross functional – Desenvolvedores, UX, SM (Scrum Master), PO (Product Owner) e QA, precisando validar uma ideia de plataforma de inscrição online para um evento. Algumas discussões surgiram durante a fase de inception para criação do produto:

- E se uma campanha promocional estiver disponível durante 2 semanas? Talvez melhore a taxa de conversão? Os usuários que não aproveitarem a promoção podem repercutir negativamente?

- E quanto isso custa? Você consegue estimar?

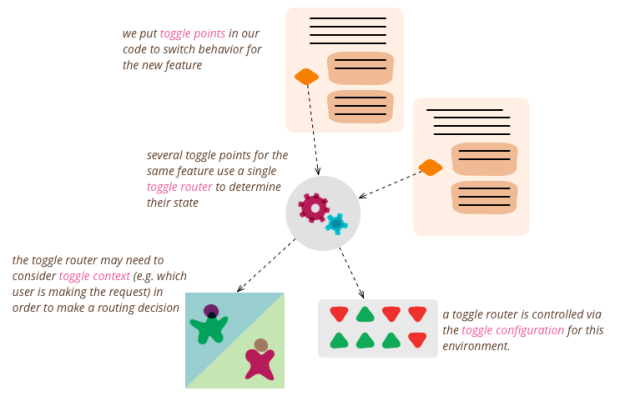

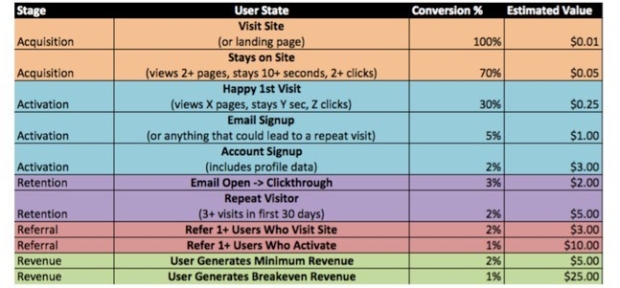

- E se ao invés de estimar, checarmos se vale a pena implementar? Acredito que realizando testes A/B podemos verificar a aceitação do público. E se aumentarmos a conversão em 10% já valeria a pena implementar.

E como ficaria tudo isso criando histórias de hipóteses (ao invés de histórias de usuários):

We believe that uma campanha promocional de 2 semanas

Will result in melhoria na conversão da inscrição

We will know we have succeeded when evoluirmos a taxa de conversão em 10% do início ao final da campanha promocional.

E assim, o Product Owner prioriza este desenvolvimento com o time e a implementação deve ocorrer em breve para confirmar se a hipótese irá gerar o valor idealizado. O time começa então a execução do backlog em gestão ágil com práticas CI/CD e apoio total do time de UI/UX para criação dos layouts e experiência do usuário. O resultado do primeiro protótipo foi aprovado e esta é a versão colocada em produção:

E após as duas semanas, verificando o progresso diariamente da conversão, o objetivo foi alcançado. Nesta jornada, foi muito importante o mindset ágil da empresa, operando com práticas DevOps e arquitetura bem estruturada que possibilitam a inovação de produtos. Ao confirmar a hipótese, podemos adotar um exemplo de aumento em receita de R$ 78.000, justificando assim um desenvolvimento na plataforma de 160 horas para implementação desta funcionalidade.

Cases de sucesso

A empresa Hello Group apresentou o uso do HDD com outras técnicas como Google Design Sprints e os livros Lean UX e The Innovator’s Hypothesis para validar hipóteses no mercado, aplicando quatro etapas: 1- Verbalize as hipóteses de que sua ideia é baseada 2- Definir a hipóteses mais críticas que pode ser testada com o menor esforço 3- Faça um plano de como testar sua hipótese 4- Descarte ou ajuste sua ideia.

Outra case de Desenvolvimento Orientado a Hipóteses é da empresa Lastminute.com, divulgado pelo CEO Tom Klein da Sabre Holdings, em que a taxa de conversão aumentou 400% em uma semana devido ao retorno da hipótese que considerava a aquisição da hospedagem premium por usuários em um hotel, de acordo com o período do dia em que eles efetuavam a reserva. A combinação das práticas HDD e CD (Continuous Delivery) amplificam o conhecimento validado, acelerando a experimentação e inovação.

Figura:

Figura:  Figura:

Figura:  Figura:

Figura:  Figura:

Figura:

Fonte:

Fonte: